Uno de los momentos más esperados del panorama SEO en España durante el 2018, ha sido sin duda alguna, la edición, un año más de Seonthebeach y más concretamente, la presentación de Gary Illyes, más conocido como @methode.

Gary empezó comentando algunos aspectos básicos y poco a poco fue entrando en temas más interesantes y polémicos como la interpretación de Javascript, la segunda oleada de indexación o las novedades del algoritmo de Google en aspectos relacionados con la velocidad.

Una de las cosas que más me llamó la atención, fue que hizo hincapié en varios puntos, que por básicos, muchas veces caen en el olvido o no se le dan suficiente importancia. Pues bien, aprovechando estas tardes veraniegas, he querido revisar en varios sitios webs estos aspectos, a priori sencillos, y la realidad es que me he encontrado con algunas sorpresas.

Vamos a empezar con uno de los puntos que deben ser sencillos y sobre los que he encontrado más problemas de los esperados, los sitemaps.

Análisis de sitemaps con Google Search Console

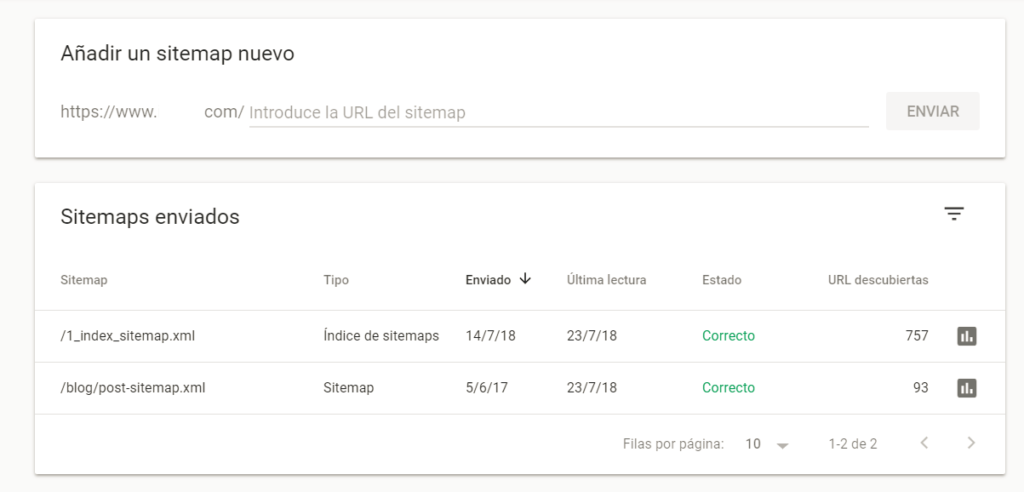

Lo primero es irnos a Google Search Console (GSC). La funcionalidad de Sitemaps es una de las que ya aparece en la nueva versión de GSC, y la forma de ver los datos y analizarlos ha cambiado.

Si utilizamos la versión nueva de GSC, tendremos directamente la opción de Sitemaps y si utilizamos la versión antigua tendremos que ir a Rastreo > Sitemap. Llegando a las siguientes pantallas respectivamente:

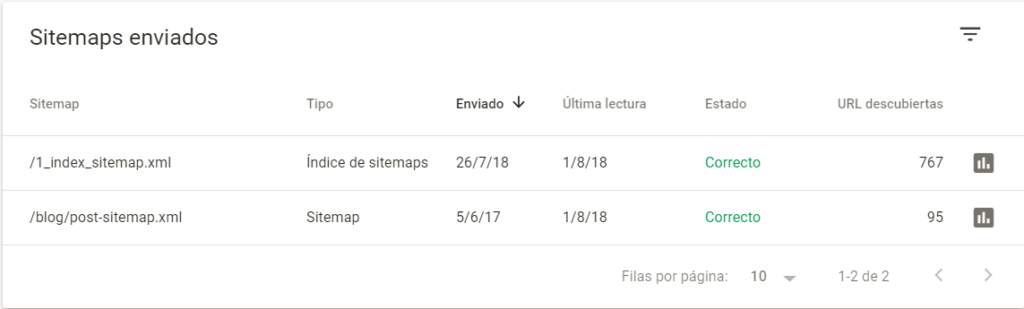

En este caso, se trata de un comercio electrónico en Prestashop con un blog en WordPress, por lo que podemos ver que dispone de dos sitemaps. El sitio web no es muy grande y en este caso no se gestionan muchas URLs.

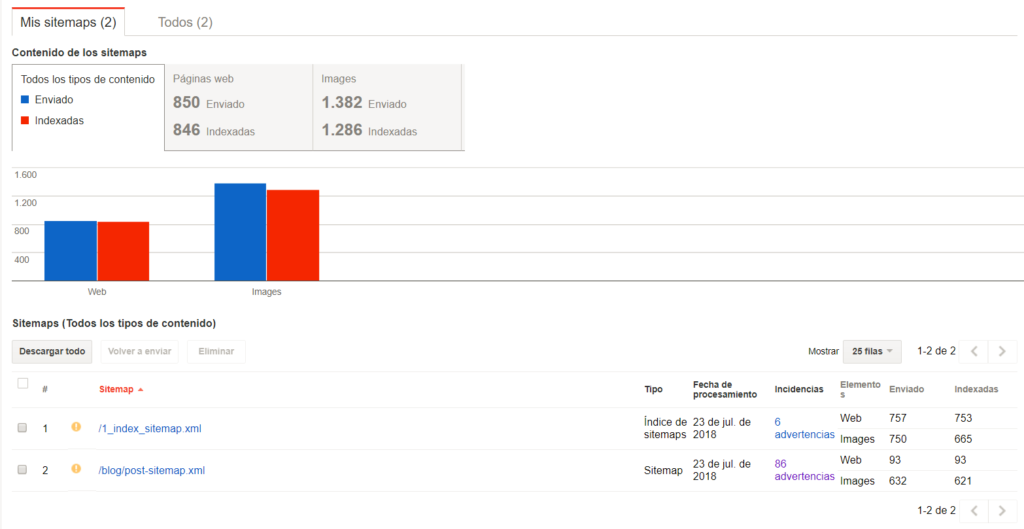

¿Qué es lo primero que nos llama la atención? En la primera visualización, si nos fijamos en la nueva versión nos dice que el sitemap está correcto, y en la versión antigua, nos indica una serie de advertencias. Pues bien, este es uno de los motivos por los que he empezado hablando de las dos opciones de analizar el sitemap con GSC, por que los datos pueden resultar confusos en muchas ocasiones.

Sitemaps en el nuevo GSC

- Revisamos las fechas de cuándo ha sido enviado y cuándo ha sido la última lectura. Además de los datos que nos encontremos aquí, recomiendo revisar que nuestros procesos automáticos para generar sitemaps están funcionando correctamente. Lo habitual es disponer de algún plug-in o módulo que automatice esta generación, pero esto lo veremos más adelante.

- Comprobamos que las URLs descubiertas concuerdan con las URLs que estamos incluyendo en el sitemap.

Una vez hechas las primeras comprobaciones, hacemos clic en el botón que aparece a la derecha de las URLs descubiertas “Cobertura del Índice”. Esto es lo que más mola, ya que desde aquí accedemos a todos los análisis de cobertura del índice del nuevo Search Console, pero solo de las URLs analizadas en el sitemap.

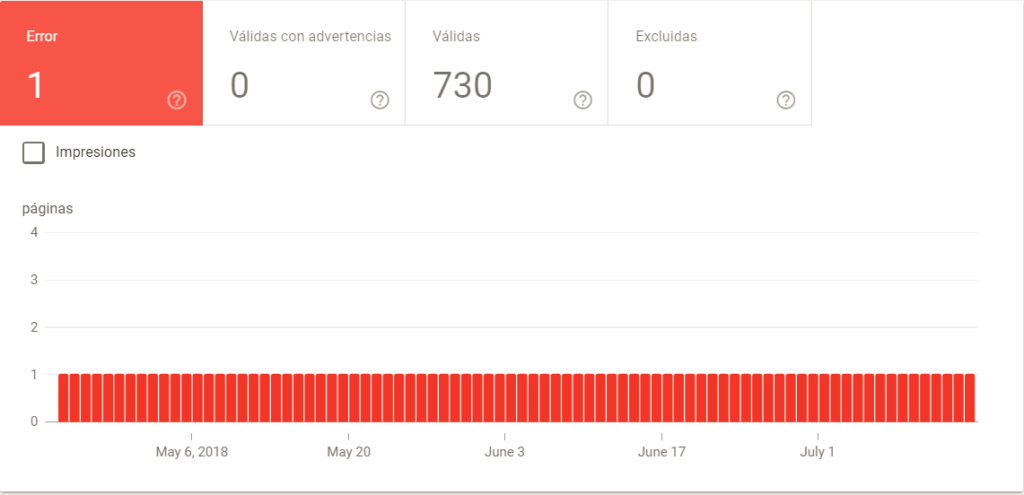

Llegamos a la siguiente pantalla:

Y esta pantalla me genera más dudas ¿Por qué me indicaba antes que estaba correcto si realmente tiene errores? ¿Por qué me decía que había 757 URLs descubiertas y me estás analizando 731?

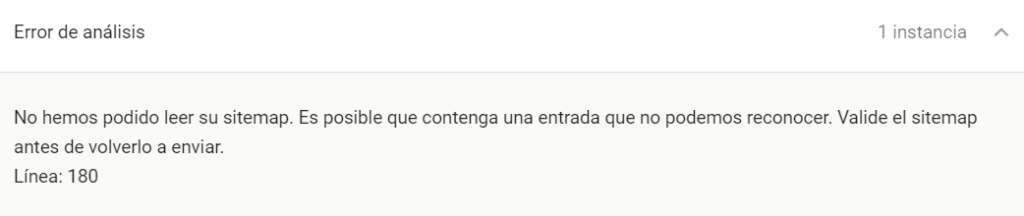

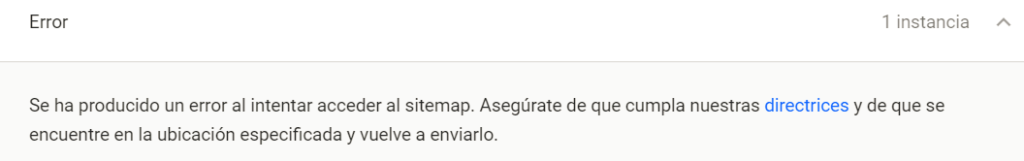

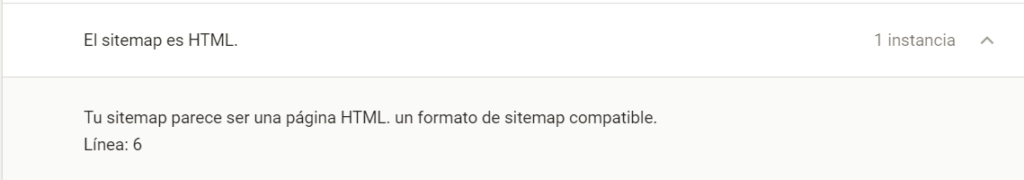

Respecto al mensaje de “Correcto”, realmente nos indica que el fichero se ha procesado correctamente, independientemente de lo que se haya encontrado con las URLs. Algunos mensajes de error que pueden aparecer cuando hay problemas en el procesamiento del sitemap son:

Por otro lado hay datos que no cuadran siempre, he vistos casos en los que me analiza más URLs de las que teóricamente está descubriendo, y otras como es el caso de arriba que analiza menos. Pero la realidad es que suele acercarse bastante.

Bien, hemos visto que en este caso había un error, y nos indica lo siguiente:

“La URL enviada tiene un problema de rastreo”

En este caso se debe a que está devolviendo 404. Otros posibles errores que he encontrado son:

“robots.txt ha bloqueado la URL enviada” “No se ha podido encontrar la URL enviada (404)” “La URL enviada contiene la etiqueta "noindex"” Error de redirección Error de servidor (5xx)

Los errores más frecuentes suelen ser bastante intuitivos, por lo que nos dice exactamente donde está el problema. Lo primero que tenemos que preguntarnos es si esa URL realmente debe estar en el sitemap o no, en el caso de que el sitemap sea correcto deberemos hacernos algunas preguntas:

Robots.txt: ¿está correctamente bloqueada en esa URL? ¿Entra en conflicto con alguna regla del robots? Si tanto el robots como el sitemap están correctos, podemos incluir un Allow:miURL para evitar que se bloquee.

Error 404: en el caso de que devuelva o 404 deberemos analizar en la web por qué está ocurriendo esto.

Noindex: ¿tiene sentido incluir en el sitemap páginas con noindex? ¿es correcto el noindex en esa página?

Redirección 3XX: ¿por qué está redireccionando esta URL? Si la redirección es correcta, ¿por qué la incluimos en el sitemap?

Error 500: Algo está pasando en el servidor y debemos analizarlo.

En segundo lugar tenemos que analizar las páginas excluidas. La realidad es que si están en el sitemap no debería excluirse, y si se tienen que excluir, no deberían incluirse en el sitemap.

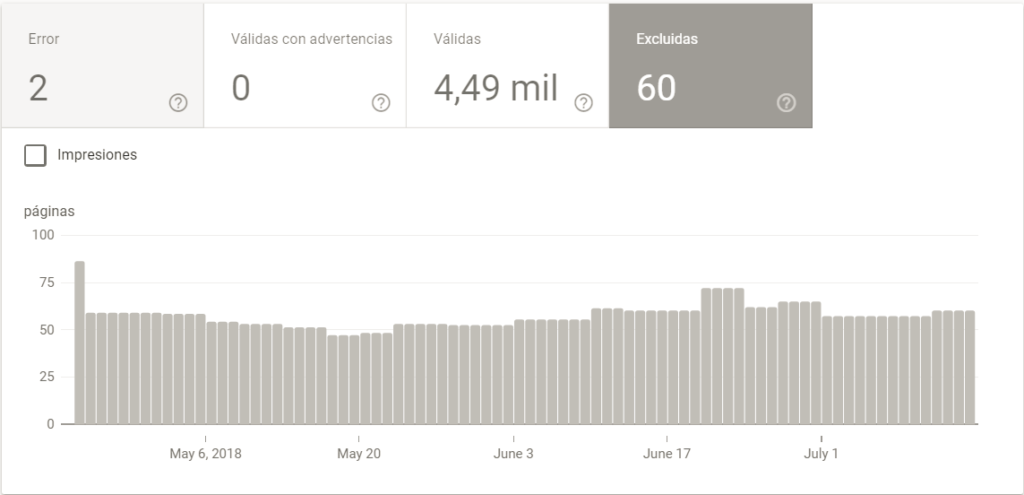

Para analizar los errores de páginas excluidas, cogemos otra web con los siguientes resultados:

En este caso nos encontramos con 60 páginas excluidas por los siguientes motivos:

La URL enviada no se ha seleccionado como canónica Rastreada: actualmente sin indexar Descubierta: actualmente sin indexar

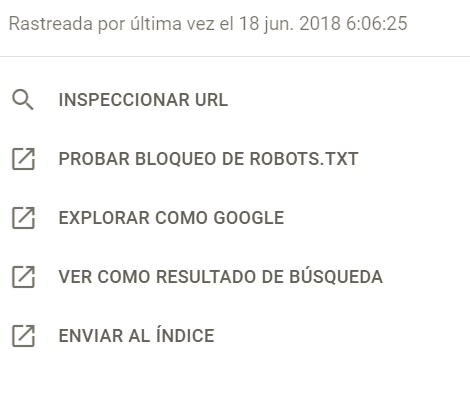

Cuando pinchamos en las diferentes opciones, podemos ver el listado de URLs a las que les afecta esa incidencia y cuando pinchamos en una URL concreta, nos da las siguientes opciones:

En los casos en los que está “actualmente sin indexar” hemos procedido enviando la URL al índice.

En los casos que nos dice que la URL enviada no es canónica, debemos analizar con más detalle cada una de las URLs. Hay casos en los que la URL que te indica está haciendo una redirección. En otros casos, haciendo clic en la opción “Inspeccionar” vemos como Google está tomando otra URL como canónica.

Faltaría ver las URLs válidas con advertencias, pero no he encontrado sitemap, con URLs de este tipo.

Como hemos visto, también podemos analizar los sitemaps con la versión antigua del Search Console ¿qué vemos en este caso?

Del mismo modo, que en la nueva versión, podemos empezar viendo si nuestro sitemap envía las URLs adecuadas y si las fechas de procesamiento son correctas.

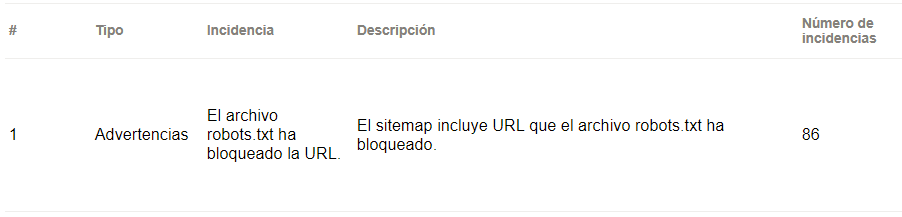

En este caso, directamente nos está mostrando advertencias. Haciendo clic en el botón de advertencias vemos el tipo de errores que presenta. Un punto en contra es que en la versión antigua, nos muestra pocos ejemplos, por lo que es difícil identificar todos los casos con errores.

Algunos de los errores que me he encontrado aquí son:

El sitemap incluye URL que el archivo robots.txt ha bloqueado.

Por lo que debemos revisar nuestro robots para ver si las reglas están correcta o debemos incluir un Allow a URLs concretas.

Algunas de las URL que aparecen en este sitemap presentan un tiempo de respuesta prolongado. Ello puede indicar que existe un problema relacionado con el servidor o con el contenido de la página.

En este caso nos toca analizar el rendimiento de las URLs.

¿Qué es lo ideal? Pues lo ideal es que todas las URLs que enviemos en el sitemap sean válidas y que se adapten a las URLs que queremos indicar a Google.

Os dejo para terminar algunos enlaces sobre sitemaps que pueden ser interesantes para aquellos que estéis trabajando en crear vuestro sitemap o en controlar los errores que encontráis:

https://www.searchenginejournal.com/surprising-seo-tactics-google-supports/259873/